本篇目录:

深度学习中的熵模型到底是啥

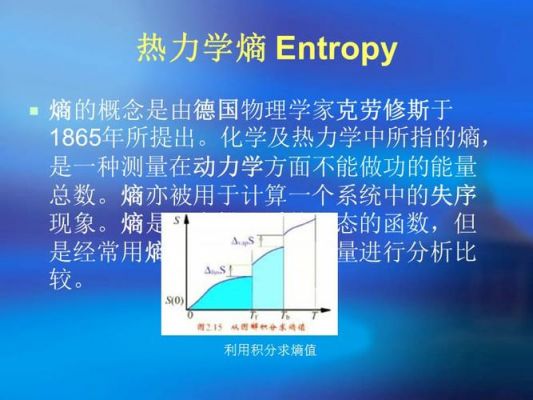

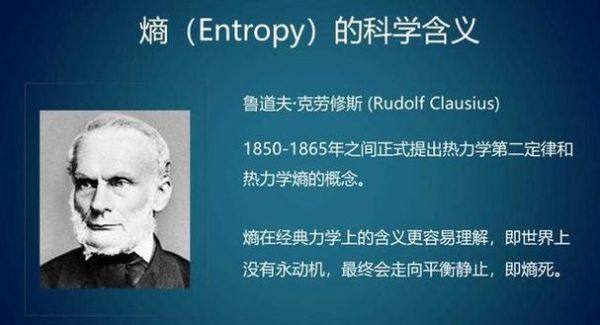

1、熵(Entropy)最初是来自热力学的一个概念,注意火字旁。本文谈论的熵是指信息熵,是香农(Claude Shannon)[1]借鉴热力学熵的公式定义的对信息的度量。组成客观世界的三大基本要素:物质、能量、信息。

2、所谓的条件最大熵模型,就是在一定约束下条件熵最大的模型。所谓的约束,也就是我们已知的信息,可以认为我们希望模型在这些信息上能和训练数据匹配。而熵最大,则表明除约束外,我们不再做未知的假设。

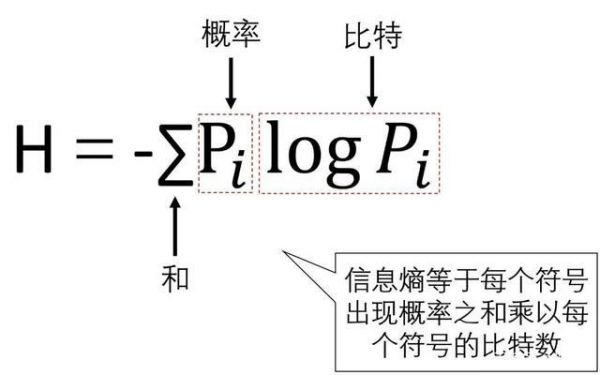

3、简单的一句话来解释就是 “熵是信息量的期望”,先给出公式: 熵的定义: 可以看到,事件的概率乘上这个时间的信息量再求和,那就是期望的定义。熵能够反映事件的不确定性,不确定性与熵成正比关系。

4、熵是对不确定性的一个正式测度。利用熵,我们可以证明不确定性、信息内容与惊喜之间的等价性。低熵对应于低不确定性,同时揭示的信息很少。信息熵 熵是用来度量与结果的概率分布相关的不确定性的。

5、熵增原理就是热力学第二定律。在热力学中,熵是用来说明热运动过程的不可逆性的物理量,反映了自然界出现的热的变化过程是有方向性的,是不可逆的。自然界是由物质和能量组成的。

6、真正的压缩程序中使用的大多是一种叫“自适应模型”的东西。自适应模型可以说是一台具有学习功能的自动机。

令人胆寒,让人顿悟的“熵增理论”

认为“在孤立的系统内,分子的热运动总是会从原来集中、有序的排列状态逐渐趋向分散、混乱的无序状态,系统从有序向无序的自发过程中,熵总是增加”,这就是所谓的“熵增原理”。

而熵增类产品的目标对象几乎是所有人,因为它符合自然规律。 让人熵增,就好比要把一个物体推下坡,只需用少许的力,因为有自然向下的自然熵增在同向作用。

现在在网络上很多人关于这种定律都表现的十分有兴趣,甚至是很多科学家对此也说过类似的话,尤其是我们所熟悉的薛定谔,这名伟大的科学家在自己的书中曾经也说过这样的话,人活着就是在对抗熵增定律,生命以负熵为生。

熵增原理就是孤立热力学系统的不减少,总是增大或者不变。说明一个孤立系统不可能朝低熵的态发展,不会变得有序。

如果物理学只能留一条定律,我会留熵增定律。说这句话的人是清华大学的科学史系主任吴国盛。在《生命是什么》中,薛定谔也说。人活着就是在对抗熵增定律,生命以负熵为生。

然而,熵增原理不会被打破,生命必然会有走到尽头的那一天。作为负熵体,生命会消耗宇宙中的有用能,从而让整个宇宙的熵变得越来越大。就目前所知,宇宙包含了一切,所以宇宙是一个孤立的系统。

如何理解信息熵

1、Shannon把信息(熵)定义为离散随机事件的出现概率。所谓信息熵,是一个数学上颇为抽象的概念,在这里不妨把信息熵理解成某种特定信息的出现概率。而信息熵和热力学熵是紧密相关的。

2、信息熵这个词是C.E.Shannon(香农)从热力学中借用过来的。热力学中的热熵是表示分子状态混乱程度的物理量。香农用信息熵的概念来描述信源的不确定度。

3、信息熵的定义为离散随机事件的出现概率 [2] 。当一个事件出现的概率更高的时候,我们认为该事件会传播的更广,因此可以使用信息熵来衡量信息的价值。

4、所谓信息熵,是一个数学上颇为抽象的概念,在这里不妨把信息熵理解成某种特定信息的出现概率。而信息熵和热力学熵是紧密相关的。

5、假定我们需要用尽可能少的二元问题来确定随机变量的取值。我们知道一个事件的信息量就是这个事件发生的概率的负对数。最后终于能回到信息熵。信息熵是跟所有可能性有关系的。每个可能事件的发生都有个概率。

6、又称为“香农熵”或“信息熵”,是一个随机变量不确定性(信息量)的度量,也可理解为随机变量在信息系统中的编码长度。

什么是信息量和信息熵,它们的用途有哪些

信息熵是描述信源本身统计特性的一个物理量。它是信源平均不定度,是信源统计特性的一个客观表征量。不管是否有接收者它总是客观存在的。

信息熵是用来 衡量事物不确定性 的。信息熵越大,事物越具不确定性,事物越复杂。

当一条信息出现的时候,也意味着背后的随机性的消失。信息熵是对系统背后所有随机可能性的度量,信息量是指特定信息能够消除多少随机性(熵)。信息熵和信息量之间的关系是什么?特定信息的出现都是有概率的。

信息熵是信息理论中的一个重要概念,它是描述信息不确定度或信息量的度量标准。这一概念最早由克劳德·香农(Claude Shannon)提出,用于量化信息的不确定性或随机性。信息熵可以理解为信息的平均不确定度或平均信息量。

信息量衡量:在信息论中,熵被用来衡量信息的量。具体来说,熵表示随机变量的不确定性或随机性。当信息熵越高时,意味着该信息的不确定性和随机性越大,其包含的信息量也就越多。

到此,以上就是小编对于与熵类似的概念的问题就介绍到这了,希望介绍的几点解答对大家有用,有任何问题和不懂的,欢迎各位老师在评论区讨论,给我留言。

微信扫一扫打赏

微信扫一扫打赏